Artikel

Wie DeepSeek's V3 & R1 KI intelligenter, billiger und sicherer machen

Die Revolution der generativen KI wurde bisher durch zwei Hindernisse gebremst: hohe Kosten und Sicherheitsbedenken. Mit der Veröffentlichung der Modelle V3 und R1 von DeepSeek hat sich das Blatt jedoch gewendet. Diese Modelle bieten modernste Leistung auf Augenhöhe mit den neuesten und besten von OpenAI und Anthropic zu einem Bruchteil der Kosten und ermöglichen gleichzeitig sichere, anpassbare Implementierungen. Dieser Wandel definiert neu, wie Unternehmen ihre GenAI-Strategie angehen. Unternehmen, die sich aufgrund von Kosten und Sicherheitsbedenken zurückgehalten haben, haben keine Ausrede mehr, um zu zögern, während diejenigen, die KI bereits nutzen, jetzt mehr Anwendungsfälle skalieren können, ohne die Bank zu sprengen.

DeepSeek V3 und R1: State-of-the-Art Leistung, jetzt zugänglich

Die neuesten Modelle von DeepSeek konkurrieren mit den LLMs in wichtigen Benchmarks, darunter Codierung, logisches Denken und kreative Aufgaben. Sie erreichen nicht nur die Leistung der Branchenführer, sondern sind kosteneffektiv und offenDas bedeutet, dass ihre Architektur und "Gewichte" (die Kerndaten, die ihre Intelligenz definieren) öffentlich zugänglich sind. Diese Kombination aus Erschwinglichkeit und Transparenz erweitert die Möglichkeiten für GenAI-Anwendungen. Lassen Sie uns nun untersuchen, wie Unternehmen die Sicherheit, Transparenz und Flexibilität zu einem Bruchteil der Kosten verbessern können.

Kontrolle, Sicherheit und Anpassung: Die Macht der offenen Modelle

Mit Modellen mit offenem Gewicht erhalten Unternehmen mehr Kontrolle über ihre KI-Systeme. Sie können:

- Hosten Sie selbst vor Ort oder in privaten Clouds und stellen Sie sicher, dass sensible Daten in ihrer Infrastruktur bleiben.

- Stimmen Sie die Modelle auf spezifische Geschäftsanforderungen ab, um die Genauigkeit und Relevanz zu verbessern.

Was ist Fine-Tuning?

Stellen Sie sich ein großes Sprachmodell wie einen Medizinstudenten vor der Facharztausbildung vor. Sie wissen ein wenig über alles, sind aber keine Experten auf einem bestimmten Gebiet. Dafür brauchen sie eine zusätzliche Ausbildung. Wenn Ihr Problem also über das Wissen des Allgemeinmediziners hinausgeht, überweist er Sie an einen Spezialisten.

Ein LLM ist ähnlich: Sie können ein leicht verfügbares Modell mit allgemeinem Wissen finden, aber wenn Ihr Anwendungsfall nicht allgemein ist, ist eine Feinabstimmung Ihres Modells von Vorteil. Die Feinabstimmung ermöglicht es Unternehmen, geschützte Informationen wie Kundeninteraktionen, Branchenjargon und Compliance-Richtlinien zu integrieren, um es zu spezialisieren. Die Feinabstimmung führt zu höherer Genauigkeit, markengerechten Ergebnissen, zeitgemäßer Relevanz, Domänenanpassung und weniger Antwortfehlern. Modelle wie GPT-4o haben im Vergleich zu offenen Modellen wie DeepSeek nur begrenzte Möglichkeiten zur Feinabstimmung.

Kosteneinsparungen ohne Kompromisse

Das Preismodell von DeepSeek bricht mit den Industrienormen und macht Hochleistungs-KI zugänglicher:

- Die API-Kosten sind bis zu 90% niedriger als GPT-4 oder Claude.

- Durch das Selbst-Hosten entfallen die Gebühren pro Abfrage, reduziert die langfristigen Kosten erheblich.

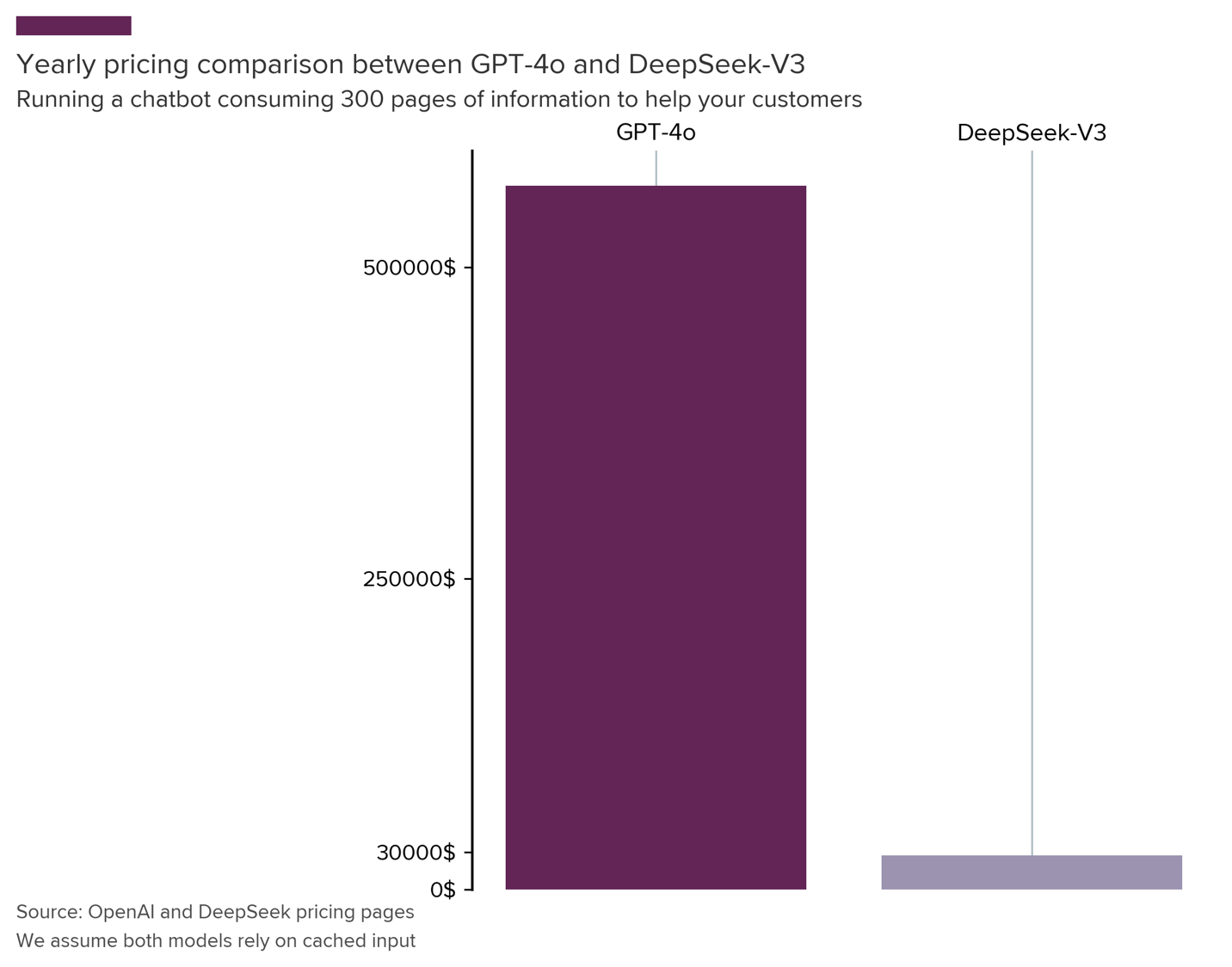

Auswirkungen in der realen Welt: Eine Chatbot-Fallstudie

Stellen Sie sich einen kundenorientierten Chatbot vor, der Benutzern helfen soll, indem er öffentlich verfügbare Informationen über Ihre Produkte nutzt. Wenn der Chatbot eine Frage nicht beantworten kann, leitet er den Kunden nahtlos an einen Live-Agenten weiter.

Stellen Sie sich nun vor, dass alle relevanten Produktinformationen in einem 300-seitigen PDF-Dokument gespeichert sind. Jedes Mal, wenn ein Kunde mit dem Chatbot interagiert, wird das gesamte Dokument gescannt, um eine Antwort zu generieren

In GenAI-parlance werden bei jeder Chat-Interaktion etwa 200.000 Token für Eingaben und 1.000 Token für Ausgaben verwendet. Der Einfachheit halber nehmen wir an, dass jedes Wort in der PDF-Datei, jede Eingabe des Kunden und jede vom Chatbot generierte Antwort als ein Token zählt. Da der Chatbot bei jeder neuen Interaktion das gesamte Dokument verarbeitet, steigt der Token-Verbrauch schnell an.

Einer unserer Unternehmenskunden hat einen ähnlichen Chatbot eingesetzt, der 5.000 Chats pro Tag bearbeitet! Der Kostenunterschied ist, wie unten gezeigt, atemberaubend.

Und das ist nur für einen einzigen GenAI-Anwendungsfall. Wir sehen viele Unternehmen, die beginnen, auf 20-30 neue Anwendungsfälle pro Jahr zu skalieren, was zu jährlichen Einsparungen in Millionenhöhe führt, ohne Kompromisse bei der Qualität einzugehen.

Die GenAI-Landschaft hat sich verändert - anpassen oder zurückfallen

DeepSeek V3 und R1 sind nicht nur schrittweise Verbesserungen. Sie stellen einen Paradigmenwechsel dar:

KI der Unternehmensklasse zu handelsüblichen Preisen

, mit unübertroffener Kontrolle und Transparenz.

Wenn Sie GenAI-Projekte aufgrund von Kosten- oder Sicherheitsbedenken verzögert haben

: Jetzt ist es an der Zeit zu handeln.- Wenn Sie GenAI bereits eingeführt haben: Bewerten Sie Ihren Stack neu. Wenn Sie an geschlossenen, teuren Modellen festhalten, riskieren Sie zu hohe Ausgaben und Stagnation.

Unternehmen, die eine offene, effiziente KI einsetzen, werden einen Wettbewerbsvorteil haben. Die Frage ist nicht, ob KI Ihre Branche verändern wird, sondern ob Sie der Entwicklung voraus sein werden oder versuchen werden, den Anschluss zu finden. Erfahren Sie in unserem Whitepaper How to Prioritize Large Language Model Use Cases, wie Sie hochwirksame KI-Initiativen identifizieren und den Wert maximieren können. Laden Sie es jetzt herunter, um einen strategischen Rahmen für Ihre LLM-Investitionen zu erhalten: Wie Sie große Sprachmodell-Anwendungsfälle priorisieren.

Handeln Sie jetzt. Ihre Konkurrenten tun es bestimmt.

Xebia kann Ihnen helfen, die Modelle von DeepSeek sicher einzusetzen, zu optimieren und zu skalieren. Sie können e xplore unser Skalierte GenAI Dienstleistungen und kontaktieren Sie uns noch heute, um eine GenAI-Strategie zu entwickeln, die den ROI maximiert, das Risiko minimiert und einen einzigartigen Geschäftswert für Ihr Unternehmen schafft.

Unsere Ideen

Weitere Artikel

Contact